最近看到,位元組的影片生成模型Seedance2.0在即夢上進行了小範圍的灰度測試。

網上去搜Seedance2.0這個模型名稱,已經有不少案例,不少人把它稱作影片領域的SOTA,甚至比最近新出的可靈3.0,Vidu Q3更為出色。

看了那些案例,有了以下基本判斷:

Seedance2.0有比Sora2更好的智慧分鏡功能,Sora2的分鏡會過於自由,隨機性過強,Seedance2.0的指令遵循能力更出色

Seedance2.0對人物動作的把控明顯增強,以前動作戲是AI的短板,但這個模型把這個短板拉長了一截,海螺的模型將不再具備優勢

Seedance2.0自己設計分鏡的效果就強於大部分人,沒必要再透過詳細的分鏡設計和首尾幀來做所有的鏡頭過渡。可以直接跳過生成分鏡圖的步驟,只需要提供場景+人物參考圖+劇本說明,模型自己能處理好的。

Seedance2.0最長能支援15s的影片生成,這就意味著,長影片不再需要一個個鏡頭去做,而只需要一段段子模組去做,生產效率upup!

有不少人說它是影片生成領域的Nano banana Pro時刻。這個說法是否客觀,本文來實際測試一下。

具體嘗試

平臺選擇

截止當前,即夢[1]上並沒有對所有使用者開放Seedance2.0這個模型,可以在影片生成頁面中,點選模型,檢視是否包含該模型。

即夢上,每個普通使用者每日有66積分,可以免費用Seedance2.0生成8秒鐘影片。

如果即夢上不包含該模型,可以用位元組跳動下的另一款產品小云雀。

它上面已經對所有使用者全量開放Seedance2.0,而且普通使用者的免費額度更高。

新使用者首次可以免費使用三次不限時長的Seedance2.0,每天登入有130積分,等價於使用Seedance2.0生成一段15秒的影片或生成兩段8秒的影片。

測試案例1

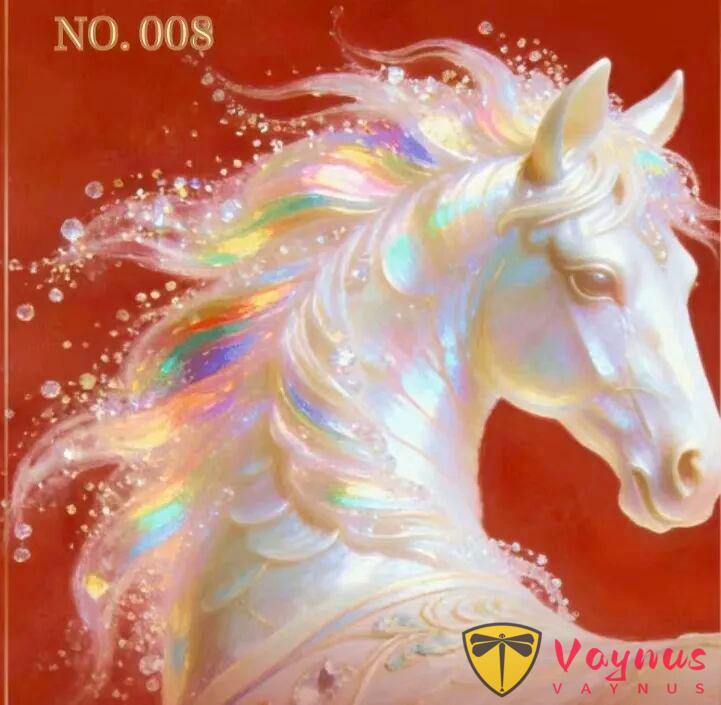

第一個案例是我嘗試用它去生成動態紅包封面。

靈感主要是看到元寶最近活動裡面有個萬元小馬卡,雖然沒抽到,但這個小馬的設計確實很帥。

於是就用AI對來擴充套件全身,並做一個動作。

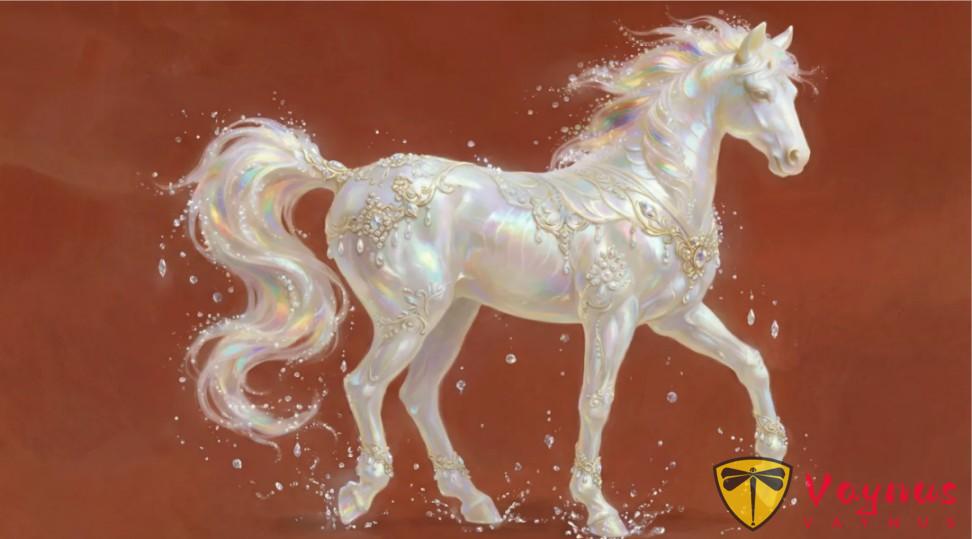

先用 Nano Banana Pro,根據這張圖,把馬的全身還原出來。

效果不賴。

然後讓GPT幫我寫了一個動作相關的提示詞:

入場:小馬從畫面左側之外緩緩進入畫面,鬃毛隨運動輕輕飄動,身體表面呈現柔和的虹彩流光,周圍有細小的光粒與水晶般的光點隨之漂浮。 停步:小馬在畫面中央略微減速停下,低頭、微微側身,抬蹄吟嘯:小馬抬起兩隻前蹄,身體略微後仰,頭部抬起,張口吟嘯;吟嘯瞬間,鬃毛如流光般向後舒展,珠光質感在身體表麵層層閃耀,光粒向外擴散,形成優雅而莊重的能量波紋。 定格收尾:吟嘯結束,小馬把馬蹄輕輕放下,恢復初始狀態,神情高貴而溫和,背景紅色穩定,整體畫面安靜、祥瑞、富有祝福意味。

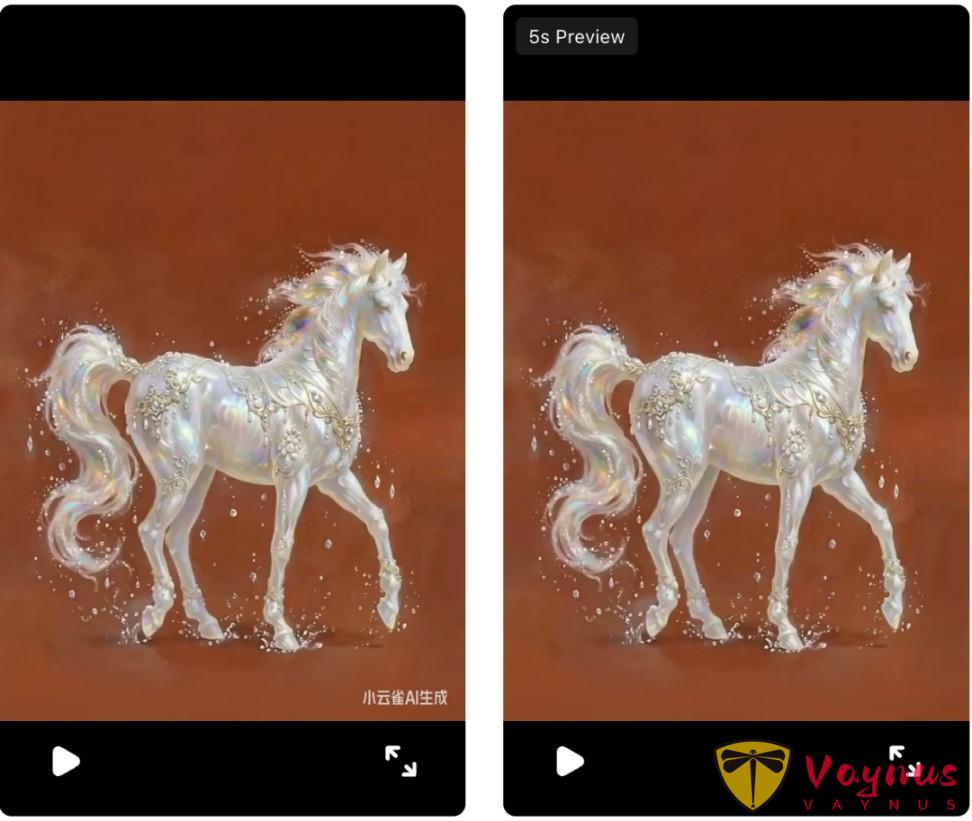

在小云雀裡面,上傳參考圖,並新增提示詞,選擇Seedance2.0模型,畫面比例改成3:4,生成5秒。

效果挺不錯,物理效果很逼真,特別是在小馬吟嘯的時候,它還自動加了彩虹的特效,這下成陽光彩虹小白馬了。

在小云雀上下載影片,會在右下角產生影片水印。

下面嘗試用ezremove[2]和vmake[3]兩個平臺對影片去除水印,效果都還不錯。

最後擷取了3秒,把它變成動態的紅包封面,快拿去成為過年的最靚的靚仔。

測試案例2

第二個案例是讓它幫我做一個電影開頭。

劇本片段描述如下:

月球轉運站,遠景。警報聲響起,二向箔播報打擊時間只剩下最後24小時。鏡頭從遠端切到近景,“所有航道已封鎖!重複,所有航道已封鎖!請未登船人員立即前往避難所!” 陳末把耳機扯下來,隨手扔在地上,金屬鞋跟碾過那團還在尖叫的塑膠。 陳默掏出一個小型的編鐘模型。鏡頭拉進到模型,回憶閃現,從模型中拉遠。

我嘗試了兩種影片生成方式。

第一種是先讓nano banana pro根據劇本生成一個3x3的九宮格分鏡,這樣能比較好的去保證片段中人物的一致性。

提示詞如下:

你是一位專業的影視創作大師,能夠精準地為我提供的劇本故事,創作對應九宮格分鏡劇照。這 9 張劇照需完美、精準地呈現劇本內容的核心意圖,完整展現故事的關鍵脈絡。創作完成後,請為每一張劇照標註對應的數字編號。畫面不要出現字幕和文字說明。劇本為以下內容:【劇本內容】

提示詞最後,再附上前面總結過的風格限定咒語:

Cinematic shot on Arri Alexa 35, Cooke cinematic lenses (non-anamorphic), natural bokeh, widescreen cinematic framing, moody cinematic atmosphere, dramatic lighting, subtle film grain, Ultra HD, hyper-realistic --ar 2.39:1 --stylize 150

生成的效果如下:

重新描述劇情,讓Seedance2.0去生成影片,

結果發現,Seedance2.0沒有傻傻地去參考所有影象,而是對內容重新重組,使其更加合理,當然,有部分字型會存在亂碼情況。

下面我又換用了另一種方式,不提前去畫九宮格分鏡圖,而是隻給人物參考圖,用語言來描述劇本內容作為提示詞,

除了部分瑕疵外,整體上感覺不用參考圖,甚至它發揮得更好。

參考圖似乎沒有存在的意義了。

價格分析

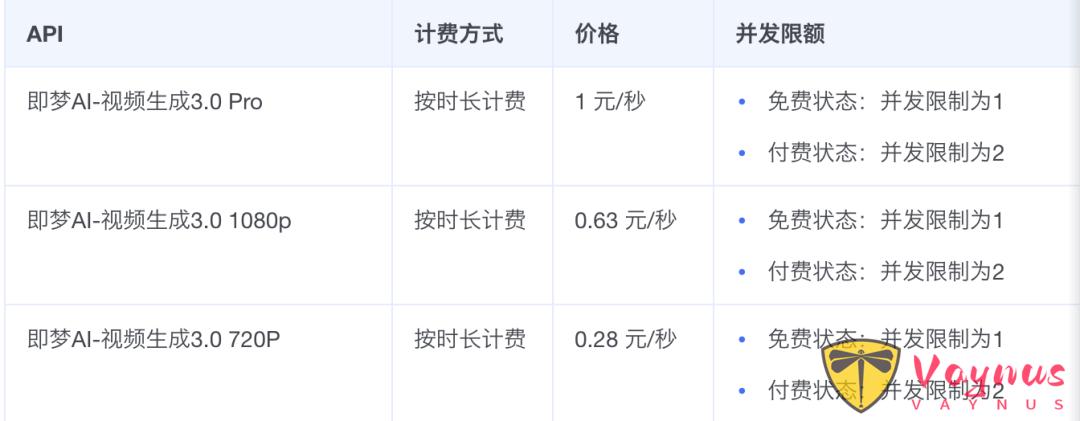

在火山引擎中,Seedance2.0這個模型對應的模型名是影片生成3.0,此外,還有一個Pro版本,沒有對外公測,但已經提供了API。

最好的模型價格是1元/秒,相比同類產品較貴,但如果降低抽卡率的角度來說,這又不算貴。

如果不用“抽卡”,5分鐘的微電影,成本就是300元,如果不用AI,只是僱個專業剪輯,每天的日薪都比這要高。

傳統的電影團隊,需要多工種的結合。而現在,單人做大片的條件確實具備了。

技術變得越來越廉價,創意和審美成爲了更稀缺的部分。

總結

試完Seedance2.0,我和好多AIGC創作者一樣,感覺很興奮。

以至於我在高鐵上都毫無睡意,一口氣寫完了這篇文章。

這個模型本質上是對AIGC創作流程的顛覆:原本的創作者需要想分鏡,需要有基礎的導演能力;但它自己有導演能力後,創作者就只需要有編劇能力就行了。

從ComfyUI到Veo3,再到Seedance2.0,技術發展的趨勢,就是讓做影片這件事,變得越來越簡單化。

再進一步,也許在未來,故事內容都不需要雕琢,幾小時的長電影,都能做到私人訂製:每個人都可以成為電影的主角,所花的電影票不是捧別人的場,而是看自己的故事。

短影片創作行業,如果不使用AI,還在用傳統流程來製作,早晚會被淘汰。

AI生成的內容無限趨於真實,速度又快數倍,所謂實拍的努力,又有什麼意義呢?

參考

[1] https://jimeng.jianying.com/ai-tool/generate

[2] https://ezremove.ai/zh/video-watermark-remover/

[3] https://vmake.ai/video-watermark-remover/upload

[4] https://www.volcengine.com/docs/85621/1544715?lang=zh