最近看到,字节的视频生成模型Seedance2.0在即梦上进行了小范围的灰度测试。

网上去搜Seedance2.0这个模型名称,已经有不少案例,不少人把它称作视频领域的SOTA,甚至比最近新出的可灵3.0,Vidu Q3更为出色。

看了那些案例,有了以下基本判断:

Seedance2.0有比Sora2更好的智能分镜功能,Sora2的分镜会过于自由,随机性过强,Seedance2.0的指令遵循能力更出色

Seedance2.0对人物动作的把控明显增强,以前动作戏是AI的短板,但这个模型把这个短板拉长了一截,海螺的模型将不再具备优势

Seedance2.0自己设计分镜的效果就强于大部分人,没必要再通过详细的分镜设计和首尾帧来做所有的镜头过渡。可以直接跳过生成分镜图的步骤,只需要提供场景+人物参考图+剧本说明,模型自己能处理好的。

Seedance2.0最长能支持15s的视频生成,这就意味着,长视频不再需要一个个镜头去做,而只需要一段段子模块去做,生产效率upup!

有不少人说它是视频生成领域的Nano banana Pro时刻。这个说法是否客观,本文来实际测试一下。

具体尝试

平台选择

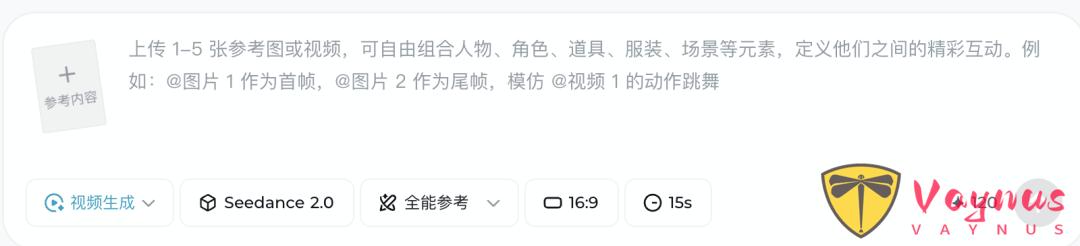

截止当前,即梦[1]上并没有对所有用户开放Seedance2.0这个模型,可以在视频生成页面中,点击模型,查看是否包含该模型。

即梦上,每个普通用户每日有66积分,可以免费用Seedance2.0生成8秒钟视频。

如果即梦上不包含该模型,可以用字节跳动下的另一款产品小云雀。

它上面已经对所有用户全量开放Seedance2.0,而且普通用户的免费额度更高。

新用户首次可以免费使用三次不限时长的Seedance2.0,每天登录有130积分,等价于使用Seedance2.0生成一段15秒的视频或生成两段8秒的视频。

测试案例1

第一个案例是我尝试用它去生成动态红包封面。

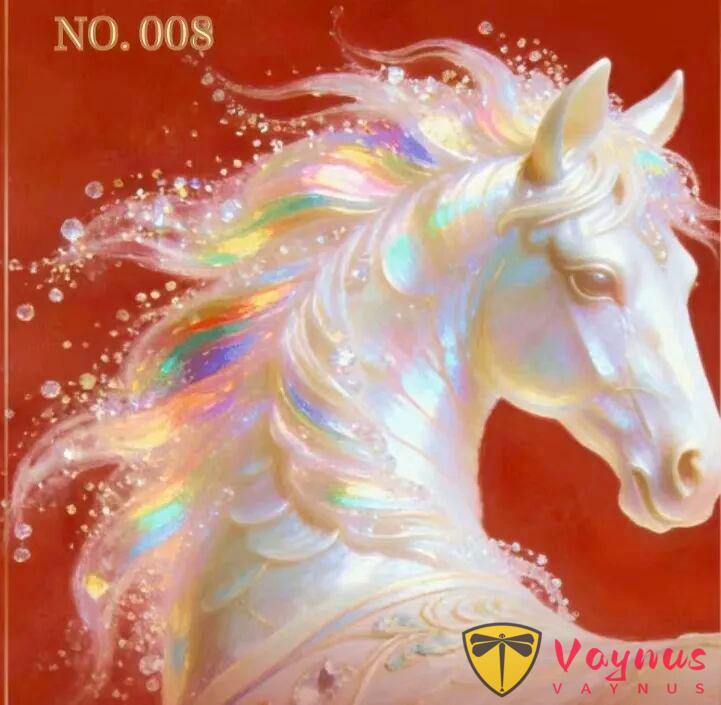

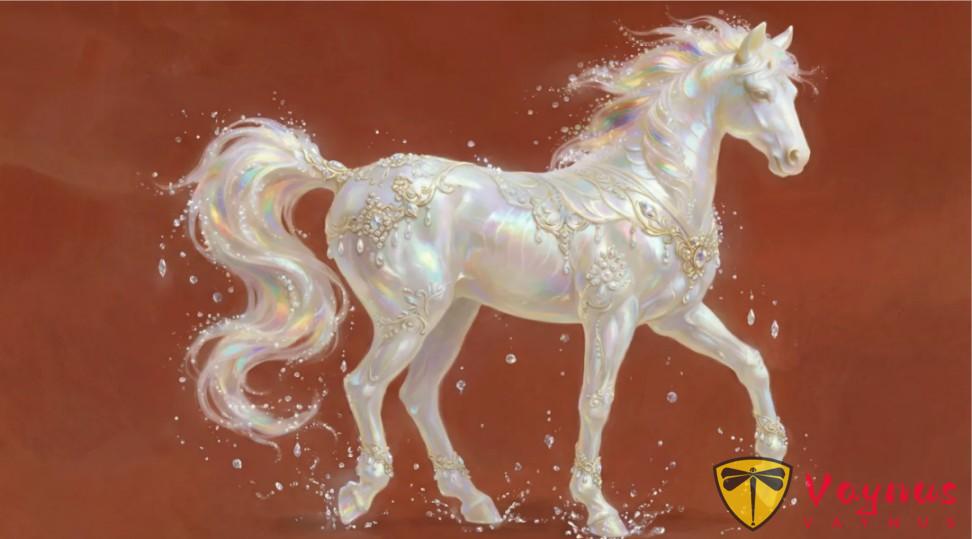

灵感主要是看到元宝最近活动里面有个万元小马卡,虽然没抽到,但这个小马的设计确实很帅。

于是就用AI对来扩展全身,并做一个动作。

先用 Nano Banana Pro,根据这张图,把马的全身还原出来。

效果不赖。

然后让GPT帮我写了一个动作相关的提示词:

入场:小马从画面左侧之外缓缓进入画面,鬃毛随运动轻轻飘动,身体表面呈现柔和的虹彩流光,周围有细小的光粒与水晶般的光点随之漂浮。 停步:小马在画面中央略微减速停下,低头、微微侧身,抬蹄吟啸:小马抬起两只前蹄,身体略微后仰,头部抬起,张口吟啸;吟啸瞬间,鬃毛如流光般向后舒展,珠光质感在身体表面层层闪耀,光粒向外扩散,形成优雅而庄重的能量波纹。 定格收尾:吟啸结束,小马把马蹄轻轻放下,恢复初始状态,神情高贵而温和,背景红色稳定,整体画面安静、祥瑞、富有祝福意味。

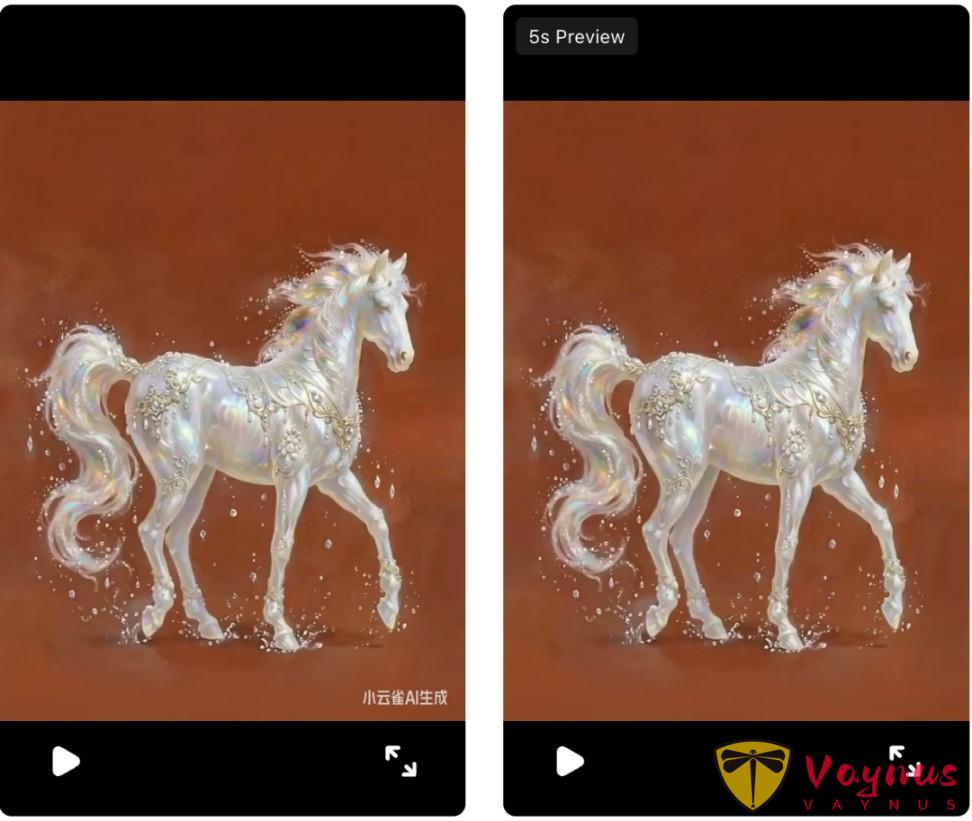

在小云雀里面,上传参考图,并添加提示词,选择Seedance2.0模型,画面比例改成3:4,生成5秒。

效果挺不错,物理效果很逼真,特别是在小马吟啸的时候,它还自动加了彩虹的特效,这下成阳光彩虹小白马了。

在小云雀上下载视频,会在右下角产生视频水印。

下面尝试用ezremove[2]和vmake[3]两个平台对视频去除水印,效果都还不错。

最后截取了3秒,把它变成动态的红包封面,快拿去成为过年的最靓的靓仔。

测试案例2

第二个案例是让它帮我做一个电影开头。

剧本片段描述如下:

月球转运站,远景。警报声响起,二向箔播报打击时间只剩下最后24小时。镜头从远端切到近景,“所有航道已封锁!重复,所有航道已封锁!请未登船人员立即前往避难所!” 陈末把耳机扯下来,随手扔在地上,金属鞋跟碾过那团还在尖叫的塑料。 陈默掏出一个小型的编钟模型。镜头拉进到模型,回忆闪现,从模型中拉远。

我尝试了两种视频生成方式。

第一种是先让nano banana pro根据剧本生成一个3x3的九宫格分镜,这样能比较好的去保证片段中人物的一致性。

提示词如下:

你是一位专业的影视创作大师,能够精准地为我提供的剧本故事,创作对应九宫格分镜剧照。这 9 张剧照需完美、精准地呈现剧本内容的核心意图,完整展现故事的关键脉络。创作完成后,请为每一张剧照标注对应的数字编号。画面不要出现字幕和文字说明。剧本为以下内容:【剧本内容】

提示词最后,再附上前面总结过的风格限定咒语:

Cinematic shot on Arri Alexa 35, Cooke cinematic lenses (non-anamorphic), natural bokeh, widescreen cinematic framing, moody cinematic atmosphere, dramatic lighting, subtle film grain, Ultra HD, hyper-realistic --ar 2.39:1 --stylize 150

生成的效果如下:

重新描述剧情,让Seedance2.0去生成视频,

结果发现,Seedance2.0没有傻傻地去参考所有图像,而是对内容重新重组,使其更加合理,当然,有部分字体会存在乱码情况。

下面我又换用了另一种方式,不提前去画九宫格分镜图,而是只给人物参考图,用语言来描述剧本内容作为提示词,

除了部分瑕疵外,整体上感觉不用参考图,甚至它发挥得更好。

参考图似乎没有存在的意义了。

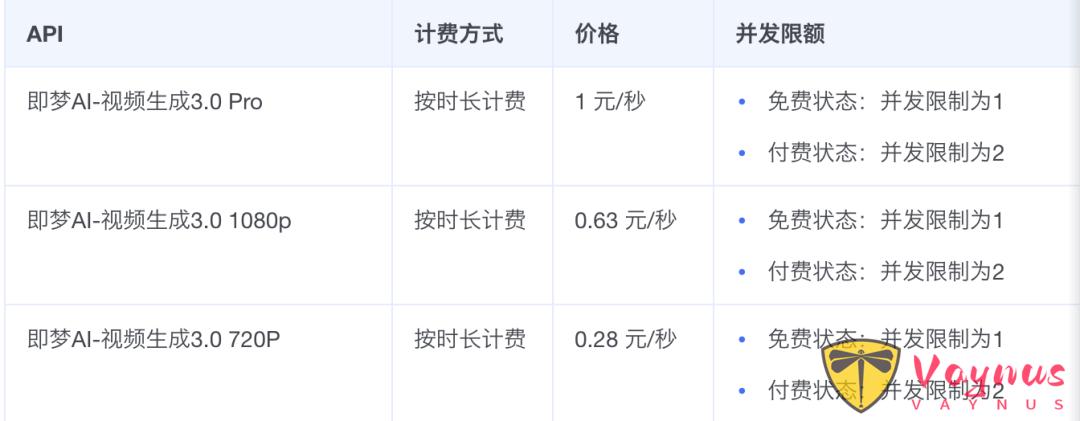

价格分析

在火山引擎中,Seedance2.0这个模型对应的模型名是视频生成3.0,此外,还有一个Pro版本,没有对外公测,但已经提供了API。

最好的模型价格是1元/秒,相比同类产品较贵,但如果降低抽卡率的角度来说,这又不算贵。

如果不用“抽卡”,5分钟的微电影,成本就是300元,如果不用AI,只是雇个专业剪辑,每天的日薪都比这要高。

传统的电影团队,需要多工种的结合。而现在,单人做大片的条件确实具备了。

技术变得越来越廉价,创意和审美成为了更稀缺的部分。

总结

试完Seedance2.0,我和好多AIGC创作者一样,感觉很兴奋。

以至于我在高铁上都毫无睡意,一口气写完了这篇文章。

这个模型本质上是对AIGC创作流程的颠覆:原本的创作者需要想分镜,需要有基础的导演能力;但它自己有导演能力后,创作者就只需要有编剧能力就行了。

从ComfyUI到Veo3,再到Seedance2.0,技术发展的趋势,就是让做视频这件事,变得越来越简单化。

再进一步,也许在未来,故事内容都不需要雕琢,几小时的长电影,都能做到私人订制:每个人都可以成为电影的主角,所花的电影票不是捧别人的场,而是看自己的故事。

短视频创作行业,如果不使用AI,还在用传统流程来制作,早晚会被淘汰。

AI生成的内容无限趋于真实,速度又快数倍,所谓实拍的努力,又有什么意义呢?

参考

[1] https://jimeng.jianying.com/ai-tool/generate

[2] https://ezremove.ai/zh/video-watermark-remover/

[3] https://vmake.ai/video-watermark-remover/upload

[4] https://www.volcengine.com/docs/85621/1544715?lang=zh